NVIDIA fabrique depuis des mois des GPU AI réduits pour contourner les restrictions américaines à l'exportation en Chine, mais il semble que des GPU AI Ampere A100 modifiés y circulent également.

VOIR LA GALERIE – 4 IMAGES

Advertisement

GPU NVIDIA A100 7936SP 96 Go + 40 Go AI (source : Jiacheng Liu)

Un nouveau NVIDIA A100 7936SP — pas le vrai nom ; ce nom est basé sur son nombre de cœurs CUDA – il possède le même GPU GA100 que l’A100 classique – mais avec 15 % de cœurs CUDA en plus. L'A100 standard dispose de 124 SM (Streaming Multiprocessors), tandis que le nouveau A100 7936SP dispose de 128 SM au total.

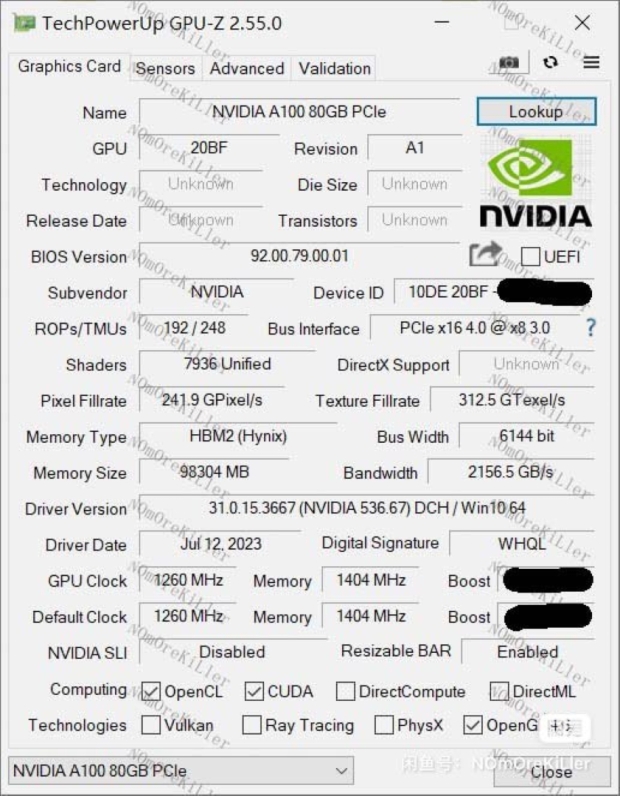

Il y a également plus de mémoire HBM2e sur le nouvel A100 7936SP, avec 96 Go de mémoire HBM2e, contre seulement 80 Go de HBM2e sur le GPU A100 AI standard. Avec les 4 SM supplémentaires, le nouvel A100 7936P a une augmentation de 15 % du nombre de SM, CUDA et Tensor Core, ce qui devrait se rapporter à au moins 15 % de performances d'IA en plus dans tous les domaines.

L'Ampère A100 de génération précédente de NVIDIA est proposé dans des configurations de 40 Go et 80 Go, tout comme le nouvel A100 7936SP avec des variantes de 80 Go et 96 Go en Chine.

Advertisement

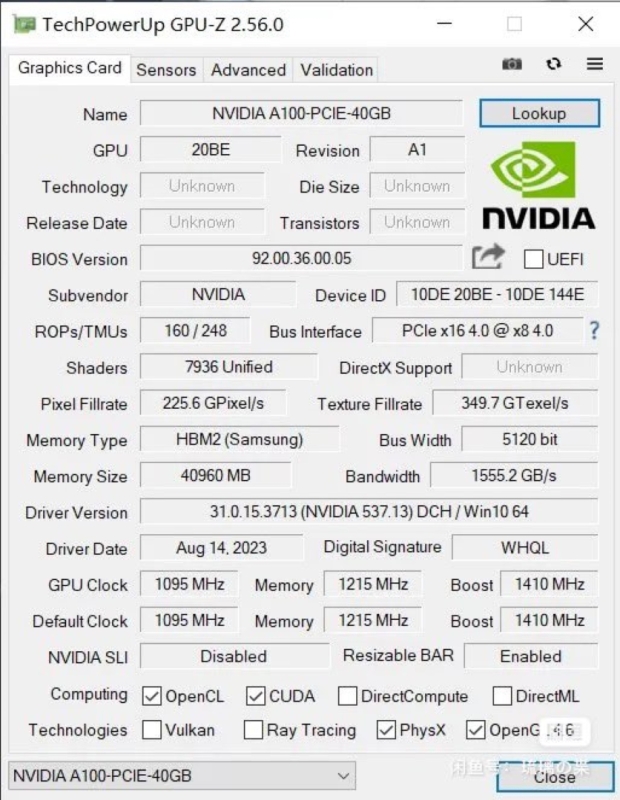

La nouvelle variante A100 7936SP 40 Go présente une énorme mise à niveau des horloges GPU de base, de 765 MHz sur l'A100 standard à un énorme 1 215 MHz (c'est un énorme augmentation de 59 %) sur le nouvel A100 7936SP. Les horloges Boost sur les variantes de 40 Go sont toutes deux à 1 410 MHz.

Quant au GPU lui-même, l'A100 7936SP 40 Go dispose de 124 SM activés, avec 7936 cœurs CUDA (duh, le nom) et 496 cœurs Tensor/AI. Pendant ce temps, l'A100 40 Go standard comprend 6912 cœurs CUDA et 432 cœurs Tensor/AI, une réduction importante par rapport au désormais méga-A100 7936SP 40 Go en Chine.

Maintenant, parlons de VRAM. Le GPU AI A100 7936SP 96 Go haut de gamme a plus de VRAM – 96 Go HBM2e contre 80 Go HBM2e sur l’A100 standard – mais il est également sur un bus plus large. Le nouveau GPU AI A100 7936SP dispose de 96 Go de mémoire HBM2e répartis sur un bus mémoire de 6 144 bits qui a jusqu'à 2,16 To/s de bande passante mémoire, en hausse par rapport au bus mémoire de 5 120 bits et à la bande passante mémoire de 1,94 To/s en temps normal. GPU IA A100 80 Go.

Le sous-système VRAM du nouvel A100 7936SP 40 Go est identique à celui de l'A100 40 Go : 40 Go de HBM2e sur un bus mémoire de 5 120 bits avec jusqu'à 1,56 To/s de bande passante mémoire.

Les GPU AI A100 80 Go et A100 40 Go actuels de NVIDIA ont des TDP de 300 W et 250 W, respectivement, nous devrions donc nous attendre à ce que l'A100 7936SP 96 Go renforcé ait un TDP légèrement plus élevé d'environ 350 W.

Nous voyons des vendeurs chinois proposer le modèle A100 7936SP 96 Go entre 18 000 et 19 800 dollars ; et nous ne savons même pas si ces accélérateurs d'IA sont des échantillons d'ingénierie qui ont été divulgués par les propres laboratoires de NVIDIA, ou des modèles personnalisés que le fabricant de puces a développés pour un client particulier. Quoi qu’il en soit, ces cartes sont réelles et elles sont plus puissantes que ne le permettent les réglementations américaines en matière d’exportation.

Advertisement