NVIDIA a enfin dévoilé son GPU Blackwell B200 AI de nouvelle génération et ses nouveaux systèmes DGX pour l'avenir de l'IA, le PDG Jensen Huang déclarant que son entreprise doit se concentrer à la fois sur la conformité et la résilience lorsqu'il s'agit de servir le marché chinois.

VOIR LA GALERIE – 3 IMAGES

Advertisement

Jensen a noté que de nombreuses parties des systèmes NVIDIA sont fabriquées en Chine, affirmant que « c'est juste la vérité » et que NVIDIA doit faire tout ce qui est en son pouvoir pour créer plus de résilience dans la chaîne d'approvisionnement. Jensen a déclaré : « Il y a deux choses que nous devons faire immédiatement. La première consiste à nous assurer que nous comprenons les politiques et que nous nous y conformons. Et l’autre est de faire tout notre possible pour créer plus de résilience dans notre chaîne d’approvisionnement.« .

Jensen a noté que de nombreux systèmes NVIDIA utilisent des pièces fabriquées en Chine, où le PDG de NVIDIA a ajouté : « C'est juste la vérité, » ajoutant que la même chose est vraie pour les industries de l'automobile et de la défense. Jensen a poursuivi : « La chaîne d’approvisionnement mondiale est assez compliquée. Nous sommes convaincus que l'objectif des nations n'est pas contradictoire… le scénario apocalyptique est peu probable.« .

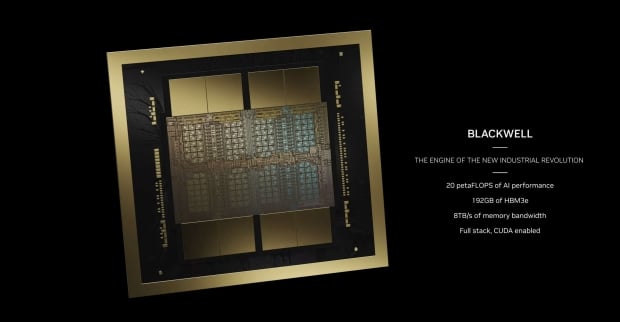

Maintenant, en ce qui concerne le nouveau GPU Blackwell B200 AI de NVIDIA : le nouveau GPU NVIDIA B200 AI comprend 208 milliards de transistors fabriqués sur le nouveau nœud de processus N4P de TSMC. Il dispose également de 192 Go de mémoire HBM3E ultra-rapide avec 8 To/s de bande passante mémoire. NVIDIA n'utilise pas ici un seul die GPU, mais un die multi-GPU avec une petite ligne entre les die différenciant les deux die, une première pour NVIDIA.

Les deux puces pensent qu'il s'agit d'une seule puce, avec 10 To/s de bande passante entre les puces GPU, qui n'ont aucune idée qu'elles sont séparées. Les deux GPU B100 pensent qu'il s'agit d'une seule puce, sans problèmes de localité de mémoire ni de problèmes de cache… il pense simplement qu'il s'agit d'un seul GPU et fait son travail (IA) à des vitesses fulgurantes, grâce au NV-HBI. (Interface NVIDIA à large bande passante).

Advertisement

Le nouveau GPU B200 AI de NVIDIA offre 20 pétaflops de performances IA à partir d'un seul GPU, contre seulement 4 pétaflops de performances IA pour le GPU H100 AI actuel. Impressionnant. Remarque : NVIDIA utilise un nouveau format de nombre FP4 pour ces nombres, le H100 utilisant le format FP8, ce qui signifie que le B200 a un calcul FP8 théorique 2,5 fois supérieur à celui du H100. Pourtant, très impressionnant.

Chacun des GPU B200 contient deux puces de taille réticule complète, avec 4 piles HBM3E de 24 Go chacune, ainsi que 1 To/s de bande passante mémoire sur une interface mémoire de 1 024 bits. Le total de 192 Go de mémoire HBM3E, avec 8 To/s de bande passante mémoire, constitue une énorme mise à niveau par rapport au GPU H100 AI, qui disposait de 6 piles HBM3 de 16 Go chacune (au début, le H200 a augmenté cela jusqu'à 24 Go par pile).

NVIDIA utilise une toute nouvelle conception de puce NVLink qui offre 1,8 To/s de bande passante bidirectionnelle et prend en charge un domaine NVLink de 576 GPU. Cette puce NVLink elle-même comporte 50 milliards de transistors, fabriqués par TSMC sur le même nœud de processus N4P.

Advertisement