Na początku tego tygodnia byliśmy na miejscu podczas konferencji Intel Vision 2024 i jedną z najfajniejszych rzeczy, które mogliśmy zobaczyć osobiście, były demonstracje sztucznej inteligencji na żywo przeprowadzone przez firmę Intel. Nie ograniczały się one tylko do wysokiej klasy sprzętu serwerowego – chociaż ludzie z Intela również z dumą mogli się nim pochwalić. Jeśli chcesz, możesz obejrzeć wideo z demonstracji na żywo na dole strony, ale jeśli się spieszysz, czytaj dalej.

Prezentowane przez nas demonstracje można ogólnie podzielić na dwie kategorie: zdalną, opartą na chmurze generatywną sztuczną inteligencję wykorzystującą akceleratory Intel Gaudi AI oraz lokalną generatywną sztuczną inteligencję wykorzystującą procesory graficzne Intel Arc, zarówno zintegrowane, jak i dyskretne. Intel pokazał nam także krótką demonstrację obciążenia AI Stable Diffusion działającego na NPU procesora Meteor Lake Core Ultra.

Advertisement

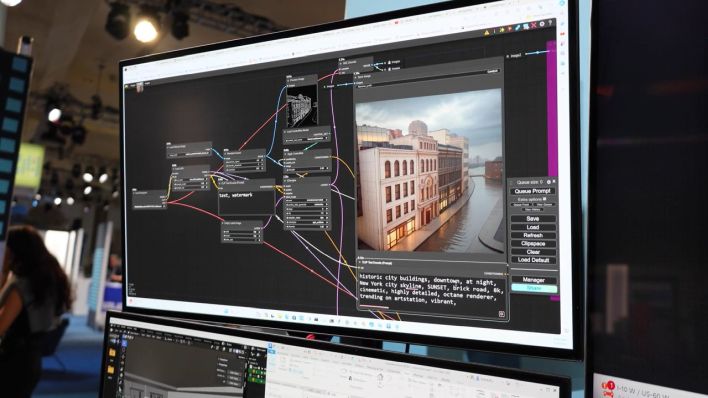

Najbardziej imponującą demonstracją była prawdopodobnie ta działająca na zintegrowanej grafice Arc w laptopie Meteor Lake. Korzystając z interfejsu społecznościowego ComfyUI o otwartym kodzie źródłowym do zapewniania stabilnej dyfuzji, Bob z firmy Intel wykorzystał wersję demonstracyjną realizmu CAD opartą na ComfyUI i Autodesk Revit, aby w ciągu zaledwie kilku sekund wygenerować fotorealistyczny obraz nowoczesnego budynku o dostosowanym projekcie. Intel podkreślił, że wszystkie narzędzia i oprogramowanie (oczywiście poza Revitem) są typu open source i są swobodnie dostępne, w tym „rozszerzenie Intel dla PyTorch” lub IPEX.

Na tej samej stacji demonstracyjnej Bob miał także komputer Dell XPS wyposażony w kartę graficzną Arc A770 16 GB. Dodatkowa pamięć RAM wideo jest ważna w przypadku obciążeń AI, które mogą potrzebować pamięci lokalnej w akceleratorach, i rzeczywiście zademonstrował znacznie bardziej imponującą wersję tego samego obciążenia, które uruchamiał na pobliskim laptopie Meteor Lake. Złożony przepływ pracy zakończony w ciągu kilku sekund; wynik naprawdę imponujący, biorąc pod uwagę parametry.

Wcześniej inny pracownik Intela pokazał nam kilka fajnych dem. Najprostszym rozwiązaniem było użycie wtyczki do programu manipulacji obrazami GNU, lepiej znanego jako GIMP. Ta wtyczka korzystała z procesora NPU procesora do generowania obrazu ze stabilną dyfuzją AI i choć wydajność nie była tak dobra, jak w przypadku drugiej maszyny korzystającej z procesora graficznego Arc, obciążenie oparte na NPU znacznie rzadziej zakłócało inne zadania na maszynie. Prawdopodobnie zużywa też mniej energii.

Druga demonstracja, którą pokazał nam David, polegała na tym, że zrobił kilka zdjęć własnej twarzy, przesłał je na serwer Intel wyposażony w akceleratory Gaudi 2, a następnie serwer ten przeszkolił niestandardowy model, który był w stanie wygenerować obrazy Davida w różnych środowiska dość odległe od środowiska centrum konferencyjnego, w którym robił zdjęcia. To było fajne demo i robiło wrażenie, jak szybko maszyna wyposażona w Gaudiego trenowała modela na zdjęciach Davida. Sądząc po stanie rynku, łatwo byłoby założyć, że stosunkowo późny start Intela na dyskretnych procesorach graficznych (w porównaniu do AMD i NVIDIA) oznacza, że Chipzilla ma ograniczoną ofertę w zakresie przetwarzania AI, ale w rzeczywistości wcale tak nie jest; Oprócz potężnych akceleratorów Gaudiego i niedrogich procesorów graficznych Arc, procesory Intela również cieszą się dużym zainteresowaniem ze względu na sztuczną inteligencję. W rzeczywistości ogromna część przetwarzania AI nadal odbywa się na procesorach i prawdopodobnie się to nie zmieni. Mówiąc to, nie wykluczaj jeszcze Intela z wyścigu AI.

Advertisement