Firma znana wcześniej jako Facebook ogłosiła wczoraj kilka ważnych ogłoszeń we współpracy z firmą Intel, która może dostarczać potężny sprzęt AI do obsługi nowych produktów AI firmy Meta. Najważniejszymi nowościami, o których warto wiedzieć, są model AI Llama 3 i nowy asystent AI Meta, zwany po prostu „Meta AI”.

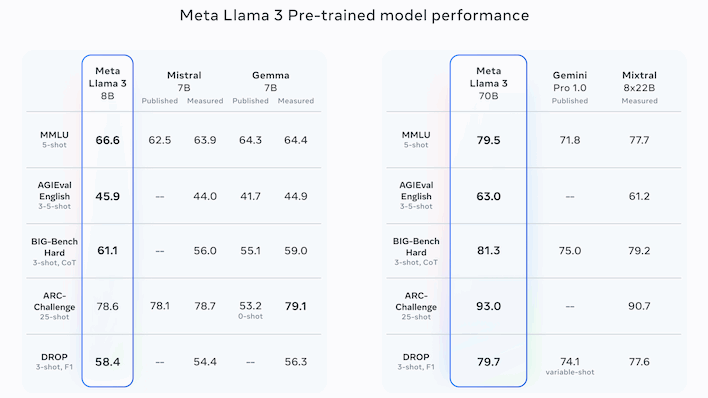

Rodzina dużych modeli językowych Meta's Llama wyróżnia się tym, że pozostaje oprogramowaniem typu open source, mimo że jest konkurencyjna pod względem wydajności w stosunku do liderów oprogramowania o zamkniętym kodzie źródłowym, takich jak seria GPT OpenAI o ironicznej nazwie i rodzina Gemini firmy Google. Najnowszą wersją Lamy jest Llama 3, która występuje w dwóch wersjach: jedna z 8 miliardami parametrów i druga z 70 miliardami parametrów.

Advertisement

Wychodząc od testów porównawczych przedstawionych przez samą Metę, pełna wersja 70B wydaje się zasadniczo konkurencyjna w stosunku do GPT-4 OpenAI – mimo że nie jest to porównanie dokonane przez samą Meta. Zamiast tego firma wydaje się skupiać na porównaniach z nieco mniej popularnymi rywalami, w tym modelami Google Gemini i Gemma oraz Claude 2 firmy Anthropic, a także modelami Mistral i Mixtral francuskiego Mistral AI.

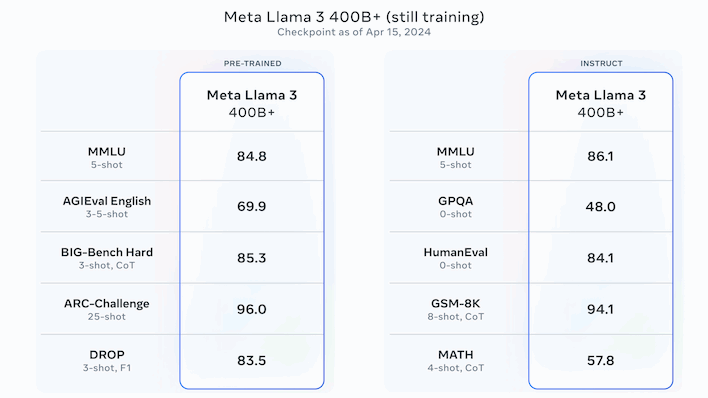

Ogólnie rzecz biorąc, liczby są przekonujące, ale Meta nie skończyła jeszcze pracować nad swoimi LLM. Meta twierdzi, że największa wersja Lamy 3, posiadająca ponad 400 miliardów parametrów, jest wciąż w fazie szkolenia. Powyższe liczby dotyczą tego modelu i są ogólnie najlepszymi, jakie widzieliśmy w przypadku prawdopodobnie wersji open source. Meta twierdzi, że Llama 3 „w nadchodzących miesiącach” doczeka się dodatkowych wydań, które dodadzą takie funkcje, jak multimodalność (obrazy, dźwięk i może wideo), obsługa wielu języków, dłuższe okno kontekstowe i wiele innych.

Warto zauważyć, że ponieważ Llama 3 jest wersją typu open source, możesz pobrać modele już teraz i bawić się nimi lokalnie. Jest jednak co do tego zastrzeżenie; musisz mieć skonfigurowane środowisko Bash, ponieważ pobieranie wymaga użycia skryptu powłoki. Powinno to być trywialne dla każdego badacza sztucznej inteligencji, większości programistów i wielu zaawansowanych użytkowników, ale jeśli jesteś zwykłym entuzjastą sztucznej inteligencji, może lepiej będzie poczekać na bardziej dostępny pakiet.

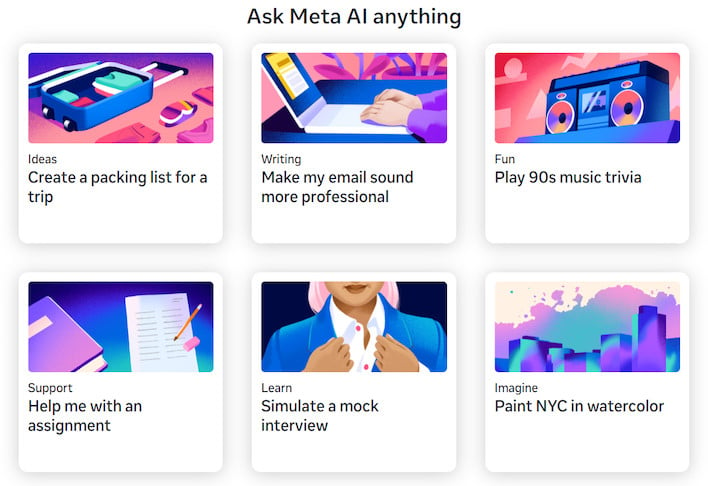

Rzeczywiście, wszystko jest w porządku, jeśli jesteś badaczem sztucznej inteligencji, ale co, jeśli jesteś zwykłym użytkownikiem? Cóż, możesz (teoretycznie) nadal wypróbować Llamę 3, korzystając z nowego asystenta Meta AI Meta. Asystent jest wbudowany w najnowsze wersje aplikacji Facebook, Instagram, WhatsApp i Messenger, gdzie może np. polecać restauracje, znajdować atrakcje związane z życiem nocnym, pomagać w edukacji lub generować zdjęcia. Można się w nią także bawić na nowej stronie Meta.ai, chociaż aby zrobić coś interesującego, musisz mieć konto na Facebooku – a my nie mogliśmy uzyskać dostępu do witryny nawet po zalogowaniu.

Advertisement

Jedną z wad tej restrukturyzacji jest to, że funkcja generowania AI Meta AI została wdrożona w nowej witrynie Meta AI. Tam, gdzie wcześniej umożliwiano użytkownikom logowanie się za pomocą kont Meta, obecnie generowanie obrazów wymaga konta na Facebooku, co prawdopodobnie zapobiegnie atakowaniu serwerów Meta przez anonimowych użytkowników żądaniami wygenerowania obrazów wymagającymi dużej mocy obliczeniowej. Nauczył się jednak kilku nowych sztuczek, w tym możliwości robienia utworzonych obrazów i iteracji na nich, a nawet animowania ich, umożliwiając użytkownikom udostępnianie ich znajomym w formacie GIF. Bardzo fajne rzeczy.

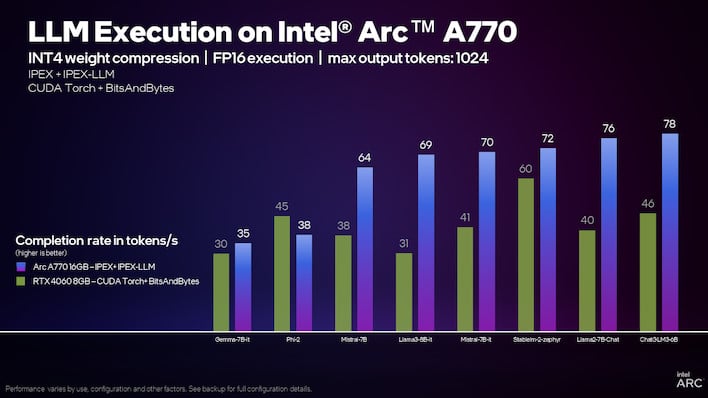

Intel twierdzi, że Arc A770 jest znacznie szybszy niż RTX 4060 w przypadku modeli językowych.

Udział Intela w nowych przedsięwzięciach Meta związanych ze sztuczną inteligencją nie jest do końca jasny, ale mimo to Intel jest do nich entuzjastycznie nastawiony. Firma opublikowała wiele publikacji i artykułów, w których przechwalała się wysoką wydajnością swoich procesorów Core Ultra i Xeon, procesorów graficznych Arc i akceleratorów Gaudi podczas działania Llama 3.

Advertisement

W szczególności firma zauważa, że zintegrowany procesor graficzny Arc w procesorze Core Ultra może „już generować [text] szybciej niż typowa prędkość odczytu przez człowieka.” Tymczasem ośmiopak chipów Gaudi 2 może najwyraźniej wygenerować około 131 zdań na sekundę, wykonując jednocześnie partię dziesięciu podpowiedzi. Nadchodzące procesory Xeon 6 będą pozornie dwa razy szybsze niż Sapphire Rapids na Lama 3 też.

Jeśli chodzi o oddzielne procesory graficzne Arc, Intel faktycznie ma rozszerzony samouczek pokazujący, jak skonfigurować model dużego języka do lokalnego działania na procesorze graficznym Arc. Pisaliśmy już o tym, gdy Intel pokazał to po raz pierwszy, ale na tym etapie efekt końcowy wydaje się znacznie bardziej przyjazny dla użytkownika — nawet jeśli proces konfiguracji jest dość skomplikowany. Jeśli masz procesor graficzny Arc i chcesz rozmawiać z LLM działającym bezpośrednio na Twoim komputerze, możesz przejdź do przewodnika Intela za przewodnik.