NVIDIA は、次世代 Blackwell B200 AI GPU を発表したばかりかもしれませんが、強化された Hopper H200 AI GPU は、最新の MLPerf 4.0 の結果でパフォーマンス記録を破っています。

ギャラリーを見る – 9 枚の画像

Advertisement

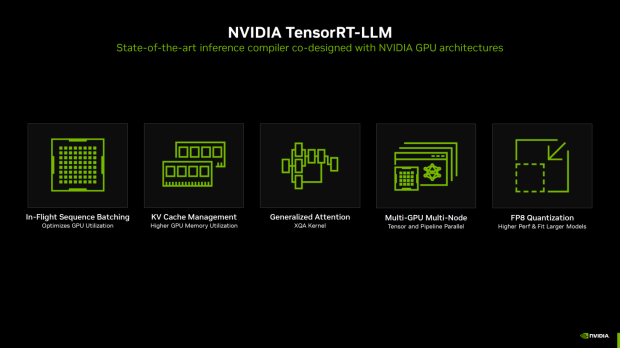

NVIDIA の TensorRT-LLM における最適化は、同社が昨年 AI ソフトウェア スイートをリリースして以来、絶え間なく進歩を続けてきました。 NVIDIA が Hopper の AI パフォーマンスを強化したことにより、MLPerf 3.1 の結果から MLPerf 4.0 までに大幅なパフォーマンスの向上が見られました。

これらの新しい TensorRT-LLM 最適化を使用して、NVIDIA は、オフライン シナリオを使用した GPT-J テストによる MLPerf Inference 3.1 から 4.0 において、現在の H100 AI GPU で 2.4 倍の大幅なパフォーマンスの飛躍を引き出しました。 GPT-J を使用したサーバーベースのシナリオでは、NVIDIA の現在の H100 AI GPU では、MLPerf 3.1 から 4.0 までのパフォーマンスが 2.9 倍と大幅に向上しました。

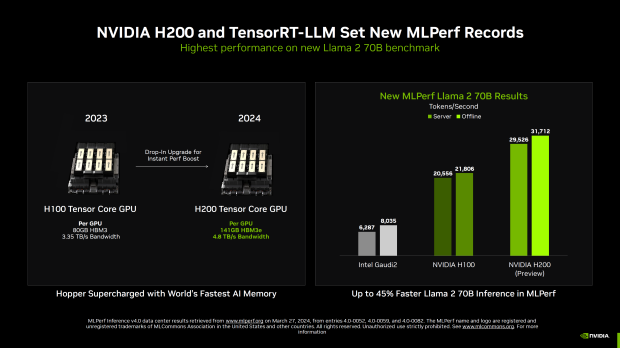

強化された H200 AI GPU と Llama 2 70B ベンチマークに移り、NVIDIA の新しい H200 AI GPU と TensorRT-LLM が新しい MLPerf 記録を樹立しました。

NVIDIA の新しい H200 Tensor コア GPU は、H100 を超えるパフォーマンスを即座に向上させるドロップイン アップグレードであり、141 GB の HBM3E (H100 では 80 GB HBM3) と、H200 の最大 4.8 TB/秒のメモリ帯域幅と、H100 の 3.35 TB/秒の帯域幅を備えています。 。 これにより、Hopper H200 が世界最速の AI メモリである HBM3E でスーパーチャージされ、AI GPU のパフォーマンスが大幅に向上します。

Advertisement

H200 は、MLPerf での Llama 70B 推論で最大 45% 高速になり、新しい世界記録を樹立しました。 NVIDIA は Intel Gaudi2 AI アクセラレータを披露しましたが、Hopper H100 AI GPU によってそれが破壊され、その後強化された H200 AI GPU によって同じ AI の優位性が急上昇し続けています。

H100 は、サーバーベースのパフォーマンスで 1 秒あたり 20,556 トークン、オフライン モードで 21,806 トークンを提供します。 一方、新しい H200 は、サーバー上で 1 秒あたり 29,526 トークン、オフラインでは 1 秒あたり 31,712 という膨大なトークンで優位に立っています。 これは、サーバーとオフラインでそれぞれ 1 秒あたりわずか 6287 トークンと 8035 トークンであり、Intel Gaudi2 が送り出すものよりも大幅に飛躍しています。

それだけでなく、NVIDIA の猛獣 HGX H200 GPU システムには 8 個の H200 AI GPU が搭載されており、サーバーとオフラインでそれぞれ 1 秒あたり 13.8 クエリと 13.7 サンプルという Stable Difffusion XL ベンチマークを打ち破っています。

NVIDIA の新しい Hopper H200 AI GPU は 700W のベース TDP を備え、カスタム設計により最大 1000W の電力を供給します。 NVIDIA の新しい Blackwell B100 は標準で 700W ですが、B200 AI GPU は用途に応じて 1200W と 1000W の設計があります。