最新の IEA 電力 2024 年レポート 米国や中国などの国のデータセンター部門からの電力および電力需要は、2030 年が始まるまでに劇的に増加すると述べています。 Google、Meta、Amazon などの AI データセンター計画を常に監視している人なら、今年だけで数十万台の高性能 NVIDIA GPU が計画されていることをご存知でしょう。さまざまな場所に設置されています。

ギャラリーを見る – 3 枚の画像

Advertisement

レポートでは、「AI サーバー市場は現在、テクノロジー企業 NVIDIA が独占しており、推定市場シェアは 95% です。2023 年に NVIDIA は 100,000 台を出荷し、年間平均 7.3 TWh の電力を消費します。2026 年までに、AI 業界は指数関数的に成長し、2023 年には需要の少なくとも 10 倍を消費すると予想されています。」

Arm の CEO、Rene Has 氏によると (via ウォールストリートジャーナル)、米国の現在の電力使用量の約 4% を AI が占めるとすると、これは 2030 年までに約 25% に上昇する可能性があります。また、同氏は、Chat GPT のような生成 AI モデルは電力に関して「飽くなき」ものであると述べました。

IEA 電力 2024 レポートによると、ChatGPT リクエスト (リクエストあたり 2.9 Wh) は、標準的な非 AI の Google 検索 (0.3 Wh の電力) の最大 10 倍の電力を消費します。 AI がユビキタスになり、オペレーティング システムから検索エンジンに至るまであらゆるものに組み込まれるようになれば、これらの生成 AI システムをオンラインに維持するための電力要件も同様になります。

説得力のあるビデオを生成する OpenAI の Sora に移ると、電力要件は指数関数的に増加します。一部のレポートでは、1 つの NVIDIA H100 AI GPU で 5 分間のビデオを生成するには 1 時間かかるとされています。 NVIDIA H100 のピーク消費電力は約 700 W で、このような AI モデルのトレーニングには 100,000 個以上の NVIDIA H100 GPU が必要です。

Advertisement

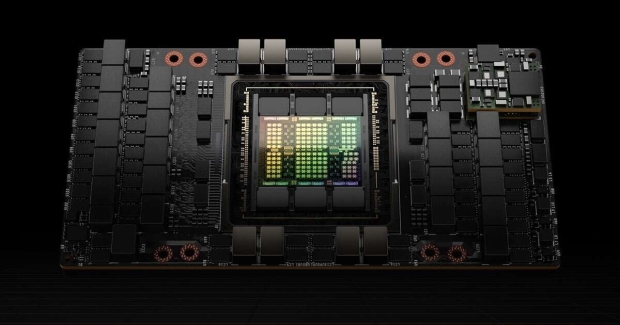

NVIDIA の H100 Tensor コア GPU、画像クレジット: NVIDIA。

良いニュースは、政府やテクノロジー企業がこの問題を認識しており、AI データセンターの隣に設置された原子力駆動の小型モジュラー炉 (SMR) の開発などの解決策を検討していることです。 ただし、このテクノロジーはまだ実証されていないため、大規模に開発および展開する必要があります。

もう1つの選択肢は、電力を大量に消費するAIデータセンターの成長と拡大を制限してAIに制限を設けることだが、その可能性は低いだろう。 IEA 電力 2024 年報告書では、効率の向上と規制が「データセンターのエネルギー消費の抑制」において重要であることが明らかにされています。 再生可能エネルギーも役割を果たします。