NVIDIA ha prodotto GPU AI ridotte per eludere le restrizioni sulle esportazioni statunitensi in Cina ormai da mesi, ma sembra che anche le GPU AI Ampere A100 modificate stiano facendo il giro lì.

VISUALIZZA GALLERIA – 4 IMMAGINI

GPU AI NVIDIA A100 7936SP 96 GB + 40 GB (fonte: Jiacheng Liu)

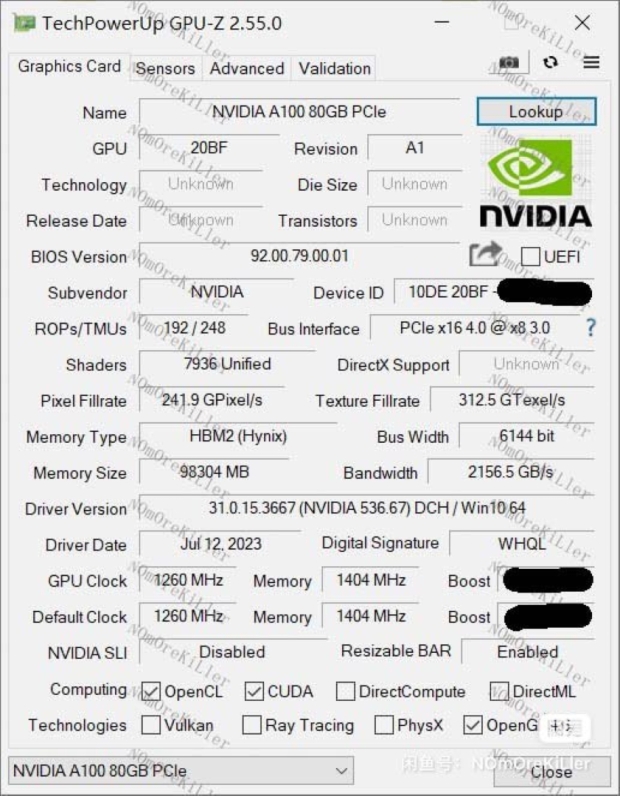

Una nuova NVIDIA A100 7936SP –non il vero nome; questo nome si basa sul numero di core CUDA: ha la stessa GPU GA100 del normale A100, ma con il 15% in più di core CUDA. Il normale A100 ha 124 SM (Streaming Multiprocessors), mentre il nuovo A100 7936SP ha 128 SM in totale.

Advertisement

C'è anche più memoria HBM2e sul nuovo A100 7936SP, con 96 GB di memoria HBM2e, rispetto ai soli 80 GB di HBM2e sulla GPU AI A100 standard. Con i 4 SM aggiuntivi, il nuovo A100 7936P ha un aumento del 15% nel numero di SM, CUDA e Tensor Core, che dovrebbe riguardare almeno il 15% in più di prestazioni AI su tutta la linea.

L'Ampere A100 di precedente generazione di NVIDIA è offerto in entrambe le configurazioni da 40 GB e 80 GB, così come il nuovo A100 7936SP con entrambe le varianti da 80 GB e 96 GB in Cina.

Advertisement

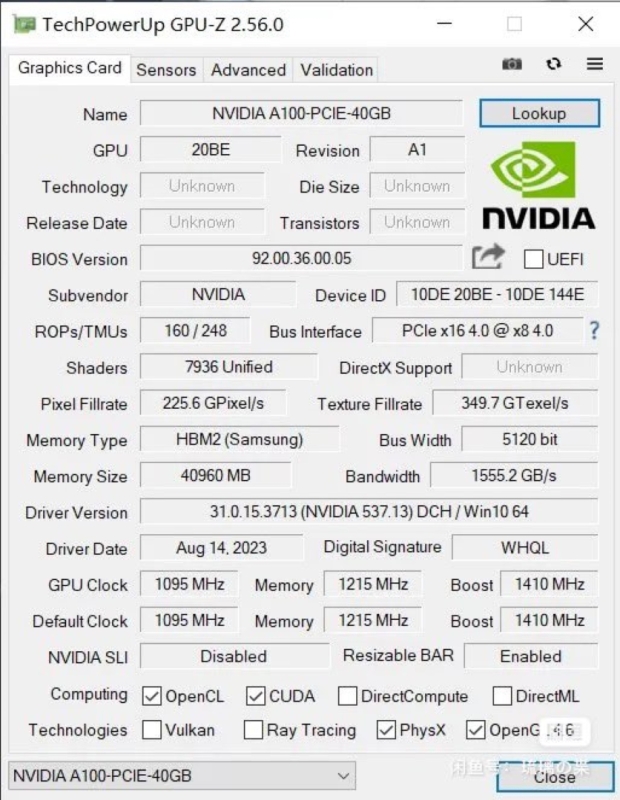

La nuova variante A100 7936SP da 40 GB ha un enorme aggiornamento nei clock della GPU di base, da 765 MHz sull'A100 standard a ben 1215 MHz (che è un enorme aumento del 59%.) sul nuovo A100 7936SP. I boost clock sulle varianti da 40 GB sono entrambi a 1410 MHz.

Per quanto riguarda la GPU stessa, l'A100 7936SP da 40 GB ha 124 SM abilitati, con 7936 core CUDA (duh, il nome) e 496 core Tensor/AI. Nel frattempo, l’A100 standard da 40 GB presenta 6912 core CUDA e 432 core Tensor/AI, un grosso taglio rispetto all’ormai mega-A100 7936SP 40 GB in Cina.

Ora parliamo di VRAM. La GPU AI A100 7936SP da 96 GB di fascia alta ha più VRAM – 96 GB HBM2e contro 80 GB HBM2e dell'A100 standard – ma è anche su un bus più ampio. La nuova GPU AI A100 7936SP ha 96 GB di memoria HBM2e distribuiti su un bus di memoria a 6144 bit che ha fino a 2,16 TB/sec di larghezza di banda di memoria, rispetto al bus di memoria a 5120 bit e 1,94 TB/sec di larghezza di banda di memoria normale. GPU AI A100 da 80 GB.

Il sottosistema VRAM sul nuovo A100 7936SP 40GB è identico all'A100 40GB: 40GB di HBM2e su un bus di memoria a 5120 bit con un massimo di 1,56TB/sec di larghezza di banda della memoria.

Le attuali GPU AI A100 da 80 GB e A100 da 40 GB di NVIDIA hanno TDP di 300 W e 250 W, rispettivamente, quindi dovremmo aspettarci che l'A100 7936SP da 96 GB potenziato abbia un TDP leggermente più alto di qualcosa come 350 W.

Stiamo vedendo venditori cinesi che elencano il modello A100 7936SP da 96 GB per un prezzo compreso tra $ 18.000 e $ 19.800; e non sappiamo nemmeno se questi acceleratori di intelligenza artificiale siano campioni di ingegneria trapelati dai laboratori di NVIDIA o modelli personalizzati che il produttore di chip ha sviluppato per un particolare cliente. Qualunque cosa sia, queste carte sono reali e sono più potenti di quanto consentito dalle normative statunitensi sulle esportazioni.