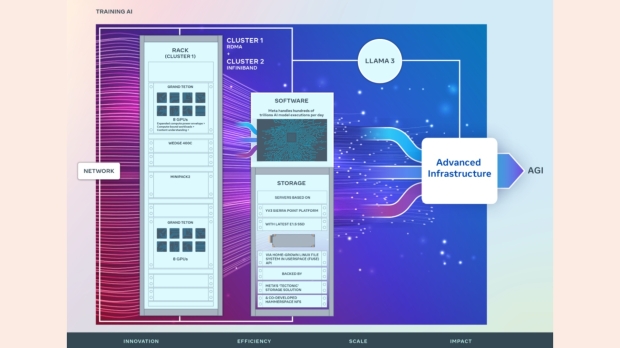

Sappiamo che l’intelligenza artificiale è un grande business ed è per questo che aziende come Microsoft, Meta, Google e Amazon stanno investendo somme di denaro da capogiro nella creazione di nuove infrastrutture e data center incentrati sull’intelligenza artificiale. Secondo l’ultimo post di Meta riguardante la sua “Infrastruttura GenAI”, l’azienda ha annunciato due “cluster su scala data center da 24.576 GPU” per supportare i modelli di intelligenza artificiale, la ricerca e lo sviluppo attuali e di prossima generazione.

Infrastruttura AI di Meta, credito immagine: Meta.

VISUALIZZA GALLERIA – 2 IMMAGINI

Si tratta di oltre 24.000 GPU NVIDIA Tensor Core H100, con Meta che aggiunge che la sua infrastruttura AI e i suoi data center ospiteranno 350.000 GPU NVIDIA H100 entro la fine del 2024. C’è solo una risposta nel vedere così tante GPU: un fischio comicamente lungo e da cartone animato o un Neo -stile “Woah”. Meta punta tutto sull’intelligenza artificiale, un mercato in cui vuole essere leader.

Advertisement

“Essere leader nello sviluppo dell’intelligenza artificiale significa guidare investimenti nell’infrastruttura hardware”, scrive il piatto. “La visione a lungo termine di Meta è quella di costruire un’intelligenza artificiale generale (AGI) che sia aperta e costruita in modo responsabile in modo che possa essere ampiamente disponibile affinché tutti possano trarne vantaggio.”

I due cluster con GPU pesanti presentano una configurazione di rete leggermente diversa; tuttavia, entrambi hanno una capacità di interconnessione di 400 Gbps. Uno presenta la soluzione di struttura di rete di Meta basata su Arista 7800 (con switch rack Wedge400 e Minipack2 OCP), mentre l’altro cluster presenta la struttura NVIDIA Quantum2. È una soluzione più all’avanguardia rispetto all’AI Research SuperCluster (RSC) di Meta, con 16.000 GPU NVIDIA A100 a partire dal 2022.

Advertisement

“L’efficienza dei tessuti di rete ad alte prestazioni all’interno di questi cluster, alcune delle decisioni chiave sullo storage, combinate con le 24.576 GPU NVIDIA Tensor Core H100 in ciascuno, consentono ad entrambe le versioni del cluster di supportare modelli più grandi e complessi di quelli che potrebbero essere supportati in l’RSC e aprire la strada ai progressi nello sviluppo dei prodotti GenAI e nella ricerca sull’intelligenza artificiale”, spiega Meta.

Meta prevede di continuare a crescere ed evolvere rapidamente la propria infrastruttura AI: “Valutiamo e miglioriamo costantemente ogni aspetto della nostra infrastruttura, dai livelli fisico e virtuale al livello software e oltre. Il nostro obiettivo è creare sistemi flessibili e affidabili per sostenere i nuovi modelli e la ricerca in rapida evoluzione.”