La società precedentemente nota come Facebook ha fatto ieri un paio di grandi annunci in collaborazione con Intel, che potrebbe fornire parte del potente hardware AI per alimentare i nuovi prodotti AI di Meta. Le grandi novità da sapere sono il modello AI di Llama 3 e il nuovo assistente AI di Meta, chiamato semplicemente “Meta AI”.

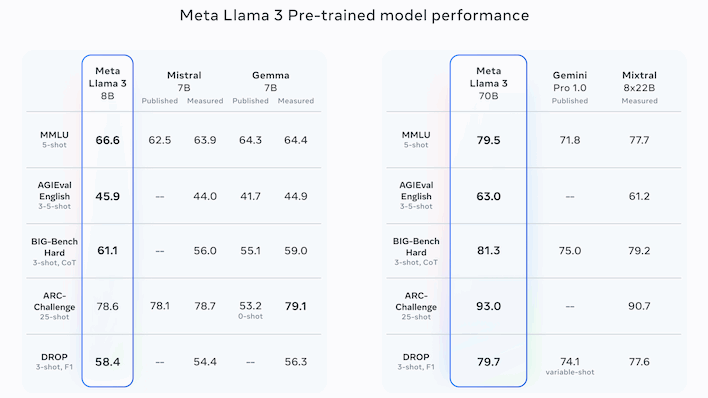

La famiglia Llama di Meta di modelli linguistici di grandi dimensioni è nota per rimanere open source nonostante sia competitiva in termini di prestazioni con i leader closed-source, come la serie GPT di OpenAI dal nome ironico e la famiglia Gemini di Google. L'ultima iterazione di Llama è Llama 3, disponibile in due versioni: una con 8 miliardi di parametri e una con 70 miliardi di parametri.

Andando oltre i benchmark presentati da Meta stessa, la versione completa 70B appare ampiamente competitiva con GPT-4 di OpenAI, anche se questo non è un confronto fatto da Meta stessa. Invece, l'azienda sembra focalizzata sul confronto con rivali un po' meno popolari, tra cui i modelli Gemini e Gemma di Google e Claude 2 di Anthropic, nonché i modelli Mistral e Mixtral della francese Mistral AI.

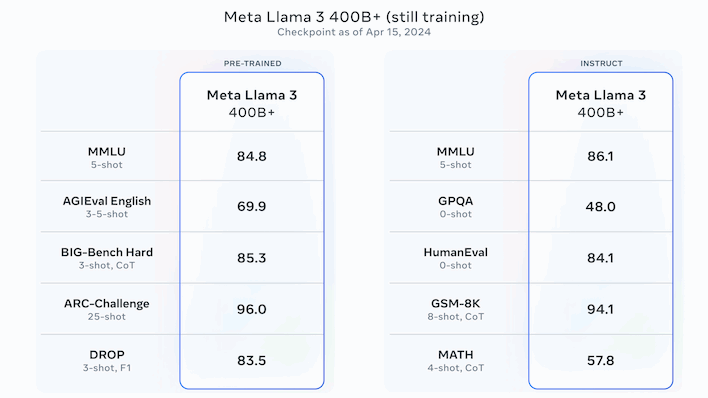

Nel complesso, i numeri sono convincenti, ma Meta non ha ancora finito di lavorare sui suoi LLM. Meta afferma che la versione più grande di Llama 3, con oltre 400 miliardi di parametri, è ancora in fase di addestramento. I numeri sopra si riferiscono a quel modello e sono nel complesso i migliori che abbiamo visto da quella che presumibilmente sarà anche una versione open source. Meta afferma che Llama 3 vedrà ulteriori versioni “nei prossimi mesi” che aggiungeranno funzionalità come la multimodalità (immagini, audio e forse video), supporto per più lingue, una finestra di contesto più lunga e altro ancora.

Advertisement

In particolare, poiché Llama 3 è open source, puoi scaricare subito i modelli e giocarci localmente. C'è un avvertimento a questo, però; dovrai avere un ambiente Bash configurato, poiché il download richiede l'uso di uno script di shell. Questo dovrebbe essere banale per qualsiasi ricercatore di intelligenza artificiale, per la maggior parte degli sviluppatori e per molti utenti esperti, ma se sei un appassionato occasionale di intelligenza artificiale, potrebbe essere meglio aspettare un pacchetto più accessibile.

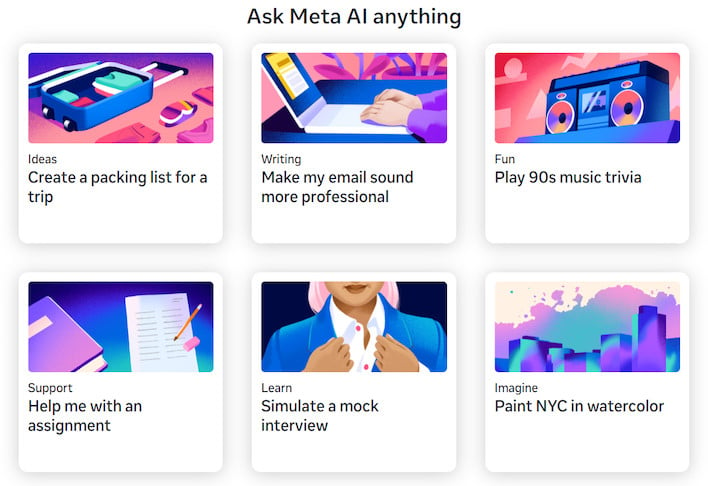

In effetti, tutto questo va bene se sei un ricercatore di intelligenza artificiale, ma cosa succede se sei un utente abituale? Bene, puoi (in teoria) ancora provare Llama 3 usando il nuovo assistente Meta AI di Meta. L'assistente è integrato nelle ultime versioni delle app Facebook, Instagram, WhatsApp e Messenger, dove può fare cose come consigliare ristoranti, trovare attività di vita notturna, assistere con l'istruzione o generare immagini. È anche disponibile per giocare sul nuovo sito, Meta.ai, anche se dovrai portare un account Facebook per fare qualcosa di interessante e non siamo riusciti ad accedere al sito anche dopo aver effettuato l'accesso.

Advertisement

Uno svantaggio di questa ristrutturazione è che la funzionalità di generazione di Imagine AI di Meta è stata implementata nel nuovo sito Meta AI. Laddove in precedenza consentiva agli utenti di accedere con account Meta, la generazione di immagini ora richiede un account Facebook, probabilmente per impedire agli utenti anonimi di intasare i server di Meta con richieste di generazione di immagini ad alta intensità di calcolo. Tuttavia, ha imparato alcuni nuovi trucchi, inclusa la possibilità di prendere le immagini create e di eseguirne l'iterazione, o addirittura di animarle, consentendo agli utenti di condividerle con gli amici in formato GIF. Roba molto interessante.

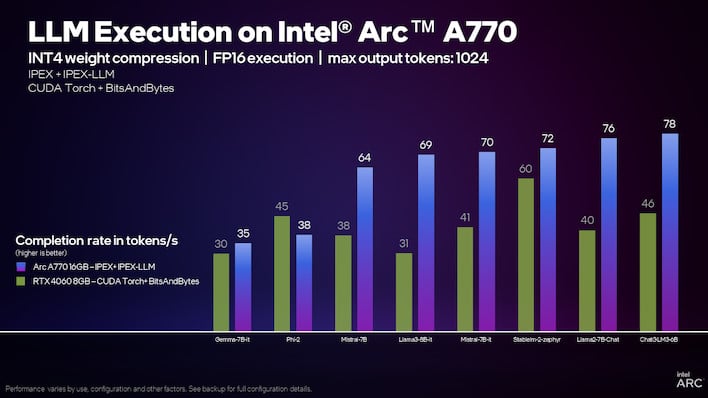

Intel afferma che l'Arc A770 è notevolmente più veloce di una RTX 4060 per i modelli linguistici.

Il ruolo di Intel nelle nuove attività di intelligenza artificiale di Meta non è del tutto chiaro, ma Intel ne è comunque entusiasta. L'azienda ha pubblicato numerosi comunicati e articoli vantandosi delle elevate prestazioni delle sue CPU Core Ultra e Xeon, delle sue GPU Arc e dei suoi acceleratori Gaudi durante l'esecuzione di Llama 3.

In particolare, l'azienda rileva che la GPU Arc integrata su una CPU Core Ultra può “già generare (testo) più velocemente della tipica velocità di lettura umana”. Nel frattempo, una confezione da otto di chip Gaudi 2 può apparentemente generare circa 131 frasi al secondo mentre esegue una serie di dieci istruzioni contemporaneamente. I suoi prossimi processori Xeon 6 sono apparentemente due volte più veloci di Sapphire Rapids su Llama 3.

Per quanto riguarda le GPU Arc discrete, Intel ha in realtà un tutorial esteso che mostra come impostare un modello linguistico di grandi dimensioni da eseguire localmente sulla tua GPU Arc. Ne abbiamo parlato quando Intel lo ha mostrato per la prima volta, ma il risultato finale a questo punto sembra notevolmente più user-friendly, anche se il processo di installazione è piuttosto contorto. Se disponi di una GPU Arc e desideri chattare con un LLM in esecuzione direttamente sul tuo PC, puoi farlo vai alla guida di Intel per la procedura dettagliata.