NVIDIA ha finalmente presentato la sua GPU AI Blackwell B200 di nuova generazione e i nuovi sistemi DGX per il futuro dell’intelligenza artificiale, con il CEO Jensen Huang che afferma che la sua azienda deve concentrarsi sia sulla conformità che sulla resilienza quando si tratta di servire il mercato cinese.

VISUALIZZA GALLERIA – 3 IMMAGINI

Jensen ha osservato che molte parti dei sistemi NVIDIA sono prodotte in Cina, affermando che “questa è proprio la verità” e che NVIDIA deve fare tutto ciò che è in suo potere per creare maggiore resilienza nella catena di fornitura. Jensen ha detto: “Ci sono due cose che dobbiamo fare subito. Uno è assicurarsi di comprendere le politiche e rispettarle. L’altro è fare tutto il possibile per creare maggiore resilienza nella nostra catena di approvvigionamento“.

Jensen ha osservato che molti dei sistemi NVIDIA utilizzano parti prodotte in Cina, dove il CEO di NVIDIA ha aggiunto: “Questa è proprio la verità” aggiungendo che la stessa cosa vale sia per l’industria automobilistica che per quella della difesa. Jensen ha continuato: “La catena di approvvigionamento del mondo è piuttosto complicata. Abbiamo piena fiducia che l’obiettivo delle nazioni non sia contraddittorio… è improbabile che si verifichi uno scenario apocalittico“.

Advertisement

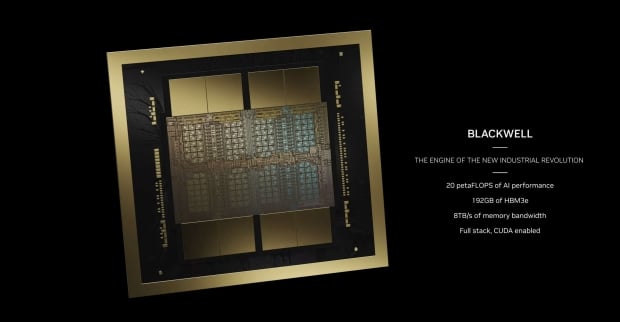

Ora, per quanto riguarda la nuova GPU AI Blackwell B200 di NVIDIA: la nuova GPU AI NVIDIA B200 presenta ben 208 miliardi di transistor realizzati sul nuovo nodo di processo N4P di TSMC. Dispone inoltre di 192 GB di memoria HBM3E ultraveloce con 8 TB/sec di larghezza di banda della memoria. NVIDIA non utilizza un singolo die GPU qui, ma un die multi-GPU con una piccola linea tra i die che differenzia i due die, una novità assoluta per NVIDIA.

I due chip pensano di essere un unico chip, con 10TB/sec di larghezza di banda tra i die della GPU, che non hanno idea di essere separati. I due die GPU B100 pensano di essere un singolo chip, senza problemi di localizzazione della memoria e di cache… pensa semplicemente che sia una singola GPU e fa il suo lavoro (AI) a velocità vertiginose, grazie a NV-HBI (Interfaccia NVIDIA a larghezza di banda elevata).

Advertisement

La nuova GPU AI B200 di NVIDIA offre 20 petaflop di prestazioni AI da una singola GPU, rispetto ai soli 4 petaflop di prestazioni AI dell’attuale GPU AI H100. Degno di nota. Nota: NVIDIA sta utilizzando un nuovo formato numerico FP4 per questi numeri, con H100 che utilizza il formato FP8, il che significa che B200 ha un calcolo teorico FP8 2,5 volte superiore rispetto a H100. Comunque, molto impressionante.

Ciascuna delle GPU B200 utilizza due chip a reticolo completo, con 4 stack HBM3E da 24 GB ciascuno, insieme a 1 TB/sec di larghezza di banda di memoria su un’interfaccia di memoria a 1024 bit. Il totale di 192 GB di memoria HBM3E, con 8 TB/sec di larghezza di banda della memoria, rappresenta un enorme aggiornamento rispetto alla GPU AI H100, che aveva 6 stack HBM3 da 16 GB ciascuno (inizialmente, H200 lo ha portato fino a 24 GB per stack).

NVIDIA utilizza un nuovissimo design di chip NVLink che ha 1,8 TB/sec di larghezza di banda bidirezionale e supporto per un dominio NVLink da 576 GPU. Questo stesso chip NVLink presenta 50 miliardi di transistor, prodotti da TSMC sullo stesso nodo del processo N4P.

Advertisement