L'ultimo Rapporto IEA Elettricità 2024 afferma che la domanda di elettricità ed energia da parte del settore dei data center in paesi come gli Stati Uniti e la Cina aumenterà notevolmente entro il 2030. Se hai tenuto traccia di alcuni dei piani per data center IA di aziende del calibro di Google, Meta, Amazon e altri, sei consapevole che solo quest'anno centinaia di migliaia di GPU NVIDIA ad alte prestazioni saranno destinate a essere installati in varie località.

VISUALIZZA GALLERIA – 3 IMMAGINI

Il rapporto scrive: “Il mercato dei server AI è attualmente dominato dall'azienda tecnologica NVIDIA, con una quota di mercato stimata del 95%. Nel 2023, NVIDIA ha spedito 100.000 unità che consumano in media 7,3 TWh di elettricità all'anno. Entro il 2026, il settore dell'intelligenza artificiale sarà si prevede che sia cresciuto in modo esponenziale fino a consumare almeno dieci volte la sua domanda nel 2023.”

Secondo Rene Has, CEO di Arm (via Il giornale di Wall Street), se l'intelligenza artificiale rappresenta circa il 4% dell'attuale consumo energetico negli Stati Uniti, questa percentuale potrebbe aumentare fino a circa il 25% entro il 2030. Ha inoltre definito “insaziabili” i modelli di intelligenza artificiale generativa come Chat GPT per quanto riguarda l'elettricità.

Advertisement

Secondo il rapporto IEA Electricity 2024, una richiesta ChatGPT (2,9 Wh per richiesta) utilizza fino a 10 volte più energia di una ricerca Google standard non AI (0,3 Wh di elettricità). Se l’intelligenza artificiale deve diventare onnipresente e incorporata in ogni cosa, dai sistemi operativi ai motori di ricerca, lo saranno anche i requisiti energetici per mantenere online questi sistemi di intelligenza artificiale generativa.

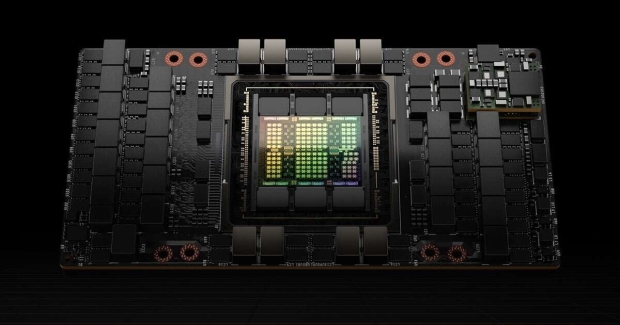

Passando a Sora di OpenAI, che genera video convincenti, il fabbisogno energetico aumenta in modo esponenziale, con alcuni rapporti che indicano che una singola GPU NVIDIA H100 AI impiegherebbe un'ora per generare un video di cinque minuti. La NVIDIA H100 ha un consumo energetico di picco di circa 700 W, con modelli IA come questo che richiedono fino a 100.000 GPU NVIDIA H100 su cui allenarsi.

Advertisement

GPU NVIDIA H100 Tensor Core, credito immagine: NVIDIA.

La buona notizia è che i governi e le aziende tecnologiche sono consapevoli del problema e stanno cercando soluzioni, incluso lo sviluppo di piccoli reattori modulari (SMR) a energia nucleare installati in loco accanto ai data center AI. Tuttavia, questa tecnologia non è ancora stata provata e deve essere sviluppata e implementata su larga scala.

L’altra opzione sarebbe quella di limitare la crescita e l’espansione dei data center IA assetati di potere per imporre restrizioni all’IA, ma ciò sembra improbabile. Il rapporto IEA Electricity 2024 chiarisce che i miglioramenti e le normative in materia di efficienza saranno cruciali per “limitare il consumo energetico dei data center”. Anche le energie rinnovabili giocheranno un ruolo.