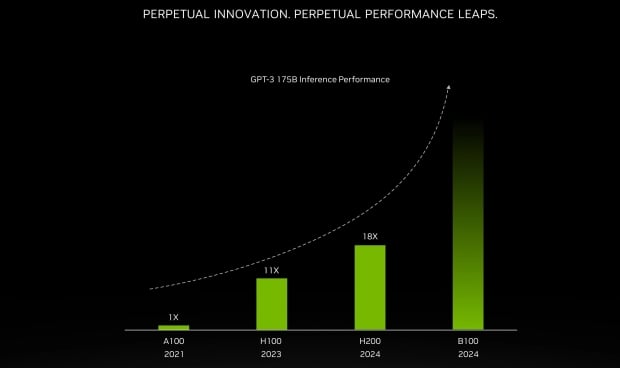

NVIDIA svelerà la sua architettura GPU Blackwell di prossima generazione al GTC 2024… domani, se puoi crederci, descrivendo in dettaglio la sua nuova GPU AI B100 e dandoci un’anticipazione della GPU AI B200 potenziata prevista per il 2025.

Anticipazioni sulle prestazioni della GPU AI B200 di nuova generazione di NVIDIA (fonte: NVIDIA)

VISUALIZZA GALLERIA – 2 IMMAGINI

In un nuovo post su X di “XpeaGPU”, sentiamo che il nuovo B100 di NVIDIA è davvero un mostro: 2 GPU muoiono sulla più recente tecnologia di packaging TSMC CoWoS-L (Chip-on-Wafer-on-Substrate-L) 2.5D , che consente alle aziende di progettare e produrre chip più grandi. La prossima generazione di NVIDIA B100 avrà fino a 192 GB di memoria HBM3E ultraveloce su stack 8-Hi, mentre la GPU AI B200 potenziata presenterà un’enorme memoria HBM3E da 288 GB.

Advertisement

L’attuale GPU AI H100 di NVIDIA viene fornita con 80 GB o 141 GB di memoria HBM3, mentre il suo concorrente, AMD Instinct MI300X, viene fornito con 192 GB di memoria HMB3. Il rilascio della GPU AI B100 vedrà NVIDIA eguagliare AMD per la quantità di memoria HBM, ma la nuova B100 di NVIDIA avrà la nuova memoria ultraveloce HBM3E e sarà la prima GPU con HBM3E sul mercato.

NVIDIA darà seguito alla sua GPU AI B100 con la nuova B200, che secondo quanto riferito presenterà stack da 12-Hi di memoria HBM3E, consentendo ben 288 GB di memoria HBM3E ultraveloce per la GPU AI definitiva. AMD ha in programma un aggiornamento per la sua GPU AI Instinct MI300, che la vedrà utilizzare la memoria HBM3E – rispetto alla HBM3 con cui viene fornita – che ha stato nel mulino delle voci recentemente.

Advertisement

NVIDIA terrà il suo keynote al GTC 2024 con il CEO Jensen Huang domani, 18 marzo, alle 13:00-15:00 PDT, che potrai controlla qui.