Un scientifique appliqué principal chez Microsoft a « avec succès » a permis à la variante multimodale d'OpenAI, GPT-4V, de jouer à DOOM, ce qui a amené le chercheur à émettre un avertissement sur les implications des systèmes avancés alimentés par l'IA.

Le scientifique de Microsoft s'appelle Adrian de Wynter, qui est également chercheur à l'Université de York en Angleterre, a rédigé un récent document de recherche avec le titre « GPT-4 exécutera-t-il DOOM ?« . En bref, GPT-4 ne peut pas exécuter DOOM car le grand modèle de langage est incapable d'exécuter directement le code source de DOOM. Cependant, sa variante multimodale, GPT-4V, ou GPT-4 avec Vision, qui est un grand modèle de langage conçu pour prendre des images et répondre à des questions à leur sujet, était capable d'agir comme un « proxy pour le moteur« .

Advertisement

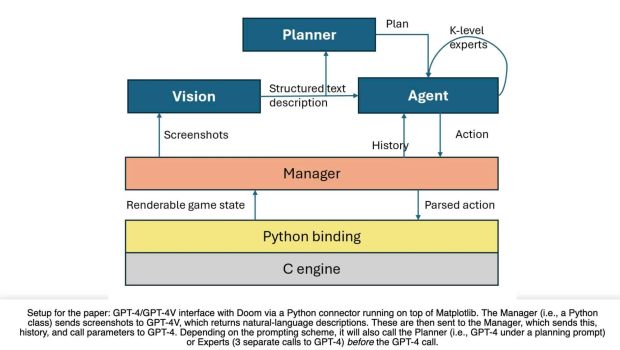

Pour y parvenir, Wynter a conçu un processus qui inclut un gestionnaire capturant des captures d'écran du moteur de jeu qui sont ensuite envoyées à GPT-4V, qui renvoie des descriptions en langage naturel de ces images. Ces descriptions sont ensuite renvoyées au Manager, qui les envoie à GPT-4, qui répond par des décisions basées sur l'historique qui lui a été envoyé. Wynter a combiné ce processus avec un modèle d'agent conçu pour traduire ses réponses en commandes de frappe qui sont ensuite saisies dans le jeu.

VOIR LA GALERIE – 2 IMAGES

« GPT-4 peut jouer à Doom à un degré passable. Maintenant,« passable »ici signifie« il fait réellement ce qu'il est censé faire, mais échoue un peu au jeu et ma grand-mère y a bien mieux joué que ce modèle ». Ce qui est intéressant, c'est qu'en effet, des schémas d'achat plus complexes (par exemple, avoir un« planificateur »générer des versions courtes de ce qu'il faut faire ensuite ; ou des experts en sondages) conduisent à de meilleurs résultats, » écrit Wynter

Le résultat est un robot alimenté par l’IA, capable d’ouvrir des portes, de combattre des ennemis, de tirer avec des armes et même des instructions exécutables susceptibles d’améliorer ses propres performances. Cela n'est pas sans problèmes, car le modèle semble manquer de permanence des objets, ou de la capacité de se rappeler où se trouvent les objets ou en particulier les ennemis. Une fois qu'un zombie dans le jeu disparaît de l'écran, l'IA l'oublie immédiatement et passe au reste du jeu.

Course naïve

Advertisement

Plus précisément, si GPT-4 oublie un zombie, il continue le jeu et finit par se retrouver coincé dans un coin, frappé par le zombie qu'il a oublié, même s'il lui est demandé quoi faire s'il subit des dégâts et ne peut pas voir l'ennemi qui l'a oublié. cause des dégâts. Sur les près de 50 à 60 courses effectuées par Wynter, il l'a observé à deux reprises faire demi-tour et affronter l'ennemi.

Même si le modèle d'IA fonctionne mal, Wynter dit qu'il considère toujours incroyable que GPT-4 soit capable d'atteindre ce niveau d'interaction avec DOOM sans aucune formation préalable. Dans le même temps, Wynter dit que c'est tout aussi troublant qu'impressionnant, car il a été assez facile de construire l'ensemble de ce processus et le modèle d'IA ne devine tout simplement aucune de ses instructions.

Wynter affirme que son processus pourrait avoir des applications dans les tests automatisés de jeux vidéo, mais prévient que le modèle ignore clairement ce qu'il fait.

« En ce qui concerne le département d'éthique, il est assez inquiétant de voir à quel point il était facile pour (a) moi de créer du code pour que le modèle tourne quelque chose ; et (b) pour que le modèle puisse tirer avec précision quelque chose sans réellement remettre en question les instructions,« , a-t-il écrit dans son message de synthèse.

Advertisement

« Ainsi, bien qu’il s’agisse d’une exploration très intéressante autour de la planification et du raisonnement, et qu’elle pourrait avoir des applications dans les tests automatisés de jeux vidéo, il est bien évident que ce modèle n’est pas conscient de ce qu’il fait. J'invite fortement tout le monde à réfléchir au déploiement de ces modèles [implies] pour la société et leur utilisation abusive potentielle.«