« Construits à partir des mêmes recherches et technologies que celles utilisées pour créer les modèles Gemini », les nouveaux Gemma LLM légers de Google ont été conçus pour fonctionner de manière native sur du matériel PC local alimenté par des GPU NVIDIA.

La nouvelle Gemma AI de Google est légère et fonctionne nativement sur un PC AI, crédit image : Google.

Advertisement

VOIR LA GALERIE – 2 IMAGES

Pour une utilisation dans des applications d’IA tierces, Gemma 2B et Gemma 7B ont tous deux été développés par Google DeepMind, chaque modèle ouvert étant capable de surpasser « des modèles nettement plus grands sur des critères clés », selon Google, tout en fonctionnant sur un ordinateur portable équipé d’une GeForce RTX. ou PC.

Les modèles pré-entraînés Gemma sont conçus pour être sûrs et fiables, avec NVIDIA ajoute que les modèles sont optimisés pour fonctionner sur sa bibliothèque open source NVIDIA TensorRT-LLM – accélérée par les plus de 100 millions de GPU NVIDIA RTX disponibles dans les PC IA. Gemma peut également fonctionner sur JAX et PyTorch.

De plus, Gemma fonctionnera également sur des GPU NVIDIA dans le cloud. Cependant, l’objectif semble être un modèle d’IA autonome et léger accessible à des millions de PC et d’ordinateurs portables. Vous pouvez tester Gemma 2B et Gemma 7B directement depuis votre navigateur via NVIDIA AI Playground en lui posant une série de questions.

Advertisement

NVIDIA a également confirmé que Gemma arriverait sur sa nouvelle plate-forme Chat with RTX, un chatbot alimenté par l’IA qui fonctionnera de manière native sur les PC Windows équipés de RTX et exécutant le logiciel TensorRT-LLM. Les développeurs ont également accès aux modèles Gemma, avec Google mettre en place un hub avec des guides de démarrage rapide couvrant la formation et le déploiement.

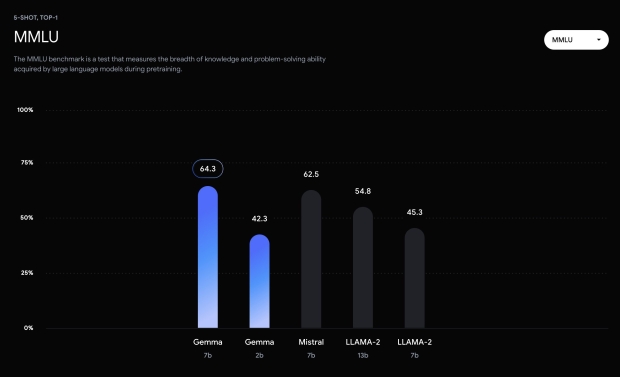

Le hub comprend également certains résultats de référence MMLU montrant que Gemma 7B surpasse les LAMA-2 7B et 13B en matière de résolution de problèmes. Pour ceux qui veulent un aperçu détaillé de Gemma, il y a un rapport technique détaillé de Google couvrant l’architecture du modèle, la formation et les résultats de référence.

« Au-delà des mesures de performance de pointe sur les tâches de référence, nous sommes impatients de voir quels nouveaux cas d’utilisation émergeront de la communauté et quelles nouvelles capacités émergeront à mesure que nous progresserons ensemble dans le domaine », écrit Google. « Nous espérons que les chercheurs utiliseront Gemma pour accélérer un large éventail de recherches, et nous espérons que les développeurs créeront de nouvelles applications, expériences utilisateur et autres fonctionnalités bénéfiques. »