Le dernier Rapport AIE Électricité 2024 déclare que la demande d’électricité et d’électricité du secteur des centres de données dans des pays comme les États-Unis et la Chine augmentera considérablement d’ici 2030. Si vous avez suivi certains des projets de centres de données IA de Google, Meta, Amazon et d'autres, vous savez que cette année seulement, des centaines de milliers de GPU NVIDIA hautes performances devraient être installés. installés à divers endroits.

VOIR LA GALERIE – 3 IMAGES

Advertisement

Le rapport écrit : « Le marché des serveurs d'IA est actuellement dominé par la société technologique NVIDIA, avec une part de marché estimée à 95 %. En 2023, NVIDIA a expédié 100 000 unités qui consomment en moyenne 7,3 TWh d'électricité par an. D'ici 2026, l'industrie de l'IA est devrait avoir connu une croissance exponentielle pour consommer au moins dix fois sa demande en 2023. »

Selon René Has, PDG d'Arm (via Le journal de Wall Street), si l'IA représente environ 4 % de la consommation électrique actuelle aux États-Unis, cela pourrait atteindre environ 25 % d'ici 2030. Il a également qualifié les modèles d'IA générative comme Chat GPT d'« insatiables » en matière d'électricité.

Selon le rapport IEA Electricity 2024, une requête ChatGPT (2,9 Wh par requête) consomme jusqu'à 10 fois plus d'énergie qu'une recherche Google standard sans IA (0,3 Wh d'électricité). Si l’IA doit devenir omniprésente et intégrée dans tout, des systèmes d’exploitation aux moteurs de recherche, les besoins en énergie pour maintenir ces systèmes d’IA génératifs en ligne le seront également.

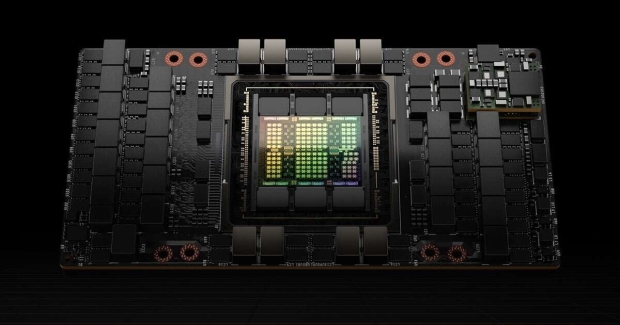

En passant à Sora d'OpenAI, qui génère des vidéos convaincantes, la consommation d'énergie augmente de façon exponentielle – certains rapports indiquant qu'il faudrait un seul GPU NVIDIA H100 AI par heure pour générer une vidéo de cinq minutes. Le NVIDIA H100 a une consommation électrique maximale d'environ 700 W, avec des modèles d'IA comme celui-ci nécessitant plus de 100 000 GPU NVIDIA H100 pour s'entraîner.

Advertisement

GPU H100 Tensor Core de NVIDIA, crédit image : NVIDIA.

La bonne nouvelle est que les gouvernements et les entreprises technologiques sont conscients du problème et recherchent des solutions, notamment en développant des petits réacteurs modulaires (SMR) à énergie nucléaire installés sur site à côté des centres de données d’IA. Cependant, cette technologie n’a pas encore fait ses preuves et doit être développée et déployée à grande échelle.

L’autre option serait de limiter la croissance et l’expansion des centres de données d’IA gourmands en énergie pour imposer des restrictions à l’IA, mais cela semble peu probable. Le rapport AIE Electricity 2024 indique clairement que les améliorations en matière d'efficacité et les réglementations seront cruciales pour « limiter la consommation d'énergie des centres de données ». Les énergies renouvelables joueront également un rôle.