La société anciennement connue sous le nom de Facebook a fait hier quelques annonces importantes en coopération avec Intel, qui pourrait fournir une partie du matériel d'IA puissant pour alimenter les nouveaux produits d'IA de Meta. Les grandes nouveautés à connaître sont le modèle d'IA de Llama 3 et le nouvel assistant IA de Meta, simplement appelé « Meta AI ».

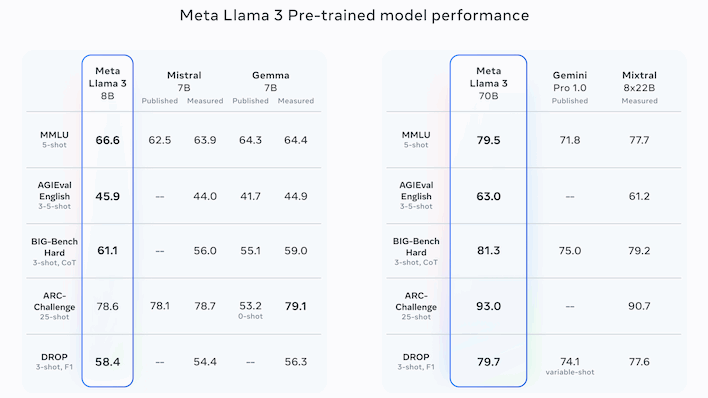

La famille Llama de grands modèles de langage de Meta se distingue par le fait qu'elle reste open source malgré ses performances compétitives avec les leaders du code source fermé, comme la série GPT d'OpenAI au nom ironique et la famille Gemini de Google. La dernière itération de Llama est Llama 3, qui se décline en deux versions : une avec 8 milliards de paramètres et une avec 70 milliards de paramètres.

Advertisement

S'écartant des références présentées par Meta lui-même, la version complète 70B semble globalement compétitive avec le GPT-4 d'OpenAI, même si ce n'est pas une comparaison faite par Meta elle-même. Au lieu de cela, la société semble se concentrer sur des comparaisons avec des concurrents un peu moins populaires, notamment les modèles Gemini et Gemma de Google et Claude 2 d'Anthropic, ainsi que les modèles Mistral et Mixtral du français Mistral AI.

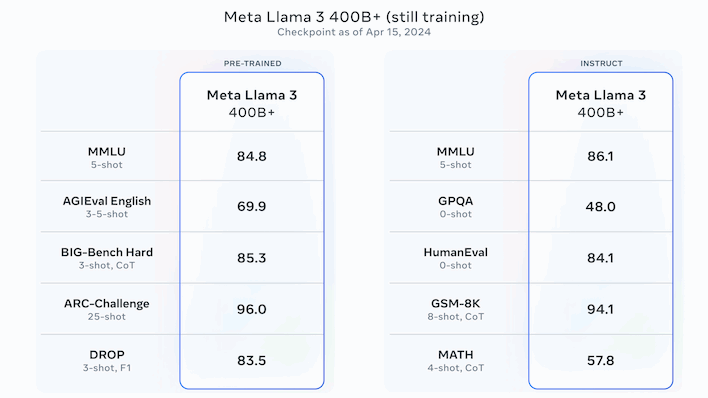

Dans l’ensemble, les chiffres sont convaincants, mais Meta n’a pas encore fini de travailler sur ses LLM. Meta indique que la plus grande version de Llama 3, avec plus de 400 milliards de paramètres, est toujours en formation. Les chiffres ci-dessus concernent ce modèle, et ils sont globalement les meilleurs que nous ayons vus pour ce qui sera probablement également une version open source. Meta indique que Llama 3 verra des versions supplémentaires « au cours des prochains mois » qui ajouteront des fonctionnalités telles que la multimodalité (images, audio et peut-être vidéo), la prise en charge de plusieurs langues, une fenêtre contextuelle plus longue, et bien plus encore.

Notamment, comme Llama 3 est open source, vous pouvez télécharger les modèles dès maintenant et jouer avec eux localement. Il y a cependant une mise en garde à cela ; vous devrez configurer un environnement Bash, car le téléchargement nécessite l'utilisation d'un script shell. Cela devrait être trivial pour tout chercheur en IA, la plupart des développeurs et de nombreux utilisateurs expérimentés, mais si vous êtes un passionné occasionnel d'IA, vous feriez peut-être mieux d'attendre un package plus accessible.

En effet, tout cela est très bien si vous êtes un chercheur en IA, mais que se passe-t-il si vous êtes un utilisateur régulier ? Eh bien, vous pouvez (en théorie) toujours essayer Llama 3 en utilisant le nouvel assistant Meta AI de Meta. L'assistant est intégré aux dernières versions des applications Facebook, Instagram, WhatsApp et Messenger, où il peut faire des choses comme recommander des restaurants, trouver des activités nocturnes, aider à l'éducation ou générer des images. Il est également disponible pour jouer sur le nouveau site Meta.ai, même si vous devrez disposer d'un compte Facebook pour faire quelque chose d'intéressant – et nous n'avons pas pu accéder au site même après vous être connecté.

Advertisement

L'un des inconvénients de cette restructuration est que la fonctionnalité de génération Imagine AI de Meta a été intégrée au nouveau site Meta AI. Alors qu'auparavant cela permettait aux utilisateurs de se connecter avec des comptes Meta, la génération d'images nécessite désormais un compte Facebook, ce qui empêchera probablement les utilisateurs anonymes de claquer les serveurs de Meta avec des requêtes de génération d'images gourmandes en calcul. Cependant, il a appris quelques nouvelles astuces, notamment la possibilité de prendre des images créées et de les parcourir, ou même de les animer, permettant aux utilisateurs de les partager avec des amis au format GIF. Des trucs très cool.

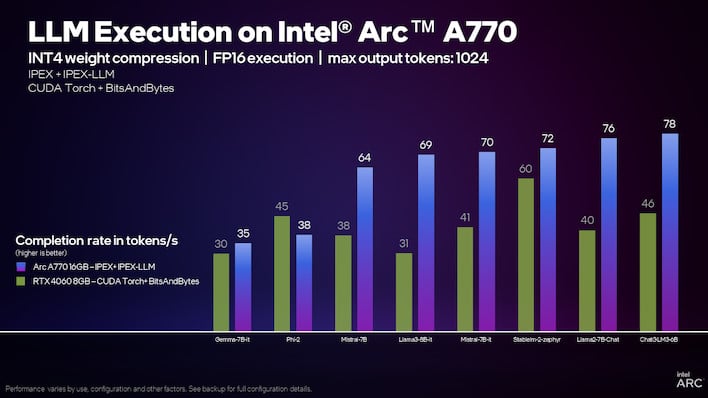

Intel affirme que l'Arc A770 est considérablement plus rapide qu'un RTX 4060 pour les modèles linguistiques.

Le rôle d'Intel dans les nouveaux efforts d'IA de Meta n'est pas tout à fait clair, mais Intel est néanmoins enthousiasmé par ces projets. La société a publié plusieurs versions et articles vantant les hautes performances de ses processeurs Core Ultra et Xeon, de ses GPU Arc et de ses accélérateurs Gaudi lors de l'exécution de Llama 3.

La société note notamment que le GPU Arc intégré sur un processeur Core Ultra peut « déjà générer [text] plus rapide que les vitesses de lecture humaines typiques. » Pendant ce temps, un pack de huit puces Gaudi 2 peut apparemment générer quelque 131 phrases par seconde tout en exécutant un lot de dix invites à la fois. Ses prochains processeurs Xeon 6 sont apparemment deux fois plus rapides que Sapphire Rapids sur Lama 3 aussi.

En ce qui concerne les GPU discrets Arc, Intel propose en fait un didacticiel étendu montrant comment configurer un grand modèle de langage à exécuter localement sur votre GPU Arc. Nous en avons parlé lorsque Intel l'a présenté pour la première fois, mais le résultat final à ce stade semble considérablement plus convivial, même si le processus de configuration est assez compliqué. Si vous disposez d'un GPU Arc et que vous souhaitez discuter avec un LLM exécuté directement sur votre PC, vous pouvez rendez-vous sur le guide d'Intel pour la procédure pas à pas.